Matthias Steffen, FUSE-AI: „Hätten wir in Deutschland doch mehr kluge Investoren und nicht nur die, die in Pizzadienste investieren!“

Matthias Steffen: „Hätten wir in Deutschland doch mehr kluge Investoren und nicht nur die, die in Pizzadienste investieren!“

Matthias Steffen berät Unternehmen aus der Gesundheitswirtschaft, wie z.B. Asklepios, Almirall, Merck aber auch Ministerien wie z.B. das Auswärtige Amt. Seine unternehmerischen Erfahrungen liegen in den Bereich Software Entwicklung und integrierter Kommunikation. Er ist in zahlreichen Verbänden tätig, wie dem BitKom, KI-Verband, BIM – Bundesverband Internet Medizin uva. Im Jahre 2016 rief er den Medical App Award ins Leben.

2017 gründete er die FUSE-AI GmbH mit drei weiteren Wissenschaftlern. Als Investor konnte das Schweizer Unternehmen XLife Sciences AG gewonnen werden. Im Jahre 2019 wurde er in den Vorstand des Life Science Nord e.V. gewählt. In regelmässigen Abständen trägt er zu Themen „KI und Medizin” auf Kongressen vor (Z.B. Gesundheitswirtschaftskongress Hamburg) und entwickelt so das Netzwerk von FUSE-AI weiter.

Gunnar Brune/AI.Hamburg: Herr Matthias Steffen, woran arbeiten Sie?

Matthias Steffen: Wir konservieren das Wissen der Chefärzte mit unserer AI-Software. Chefärzte gehen mit 65 Jahren in den Ruhestand und nehmen ihr Wissen mit. Sie haben es vielleicht ihren Assistenzärzten übergeben. Aber natürlich dauert es länger, bis diese die vollen Fähigkeiten eines alten Hasen erreicht haben. Unser Ziel ist, dass die jüngeren, nachwachsenden Ärzte von diesem Wissen der alten Chefärzte profitieren können.

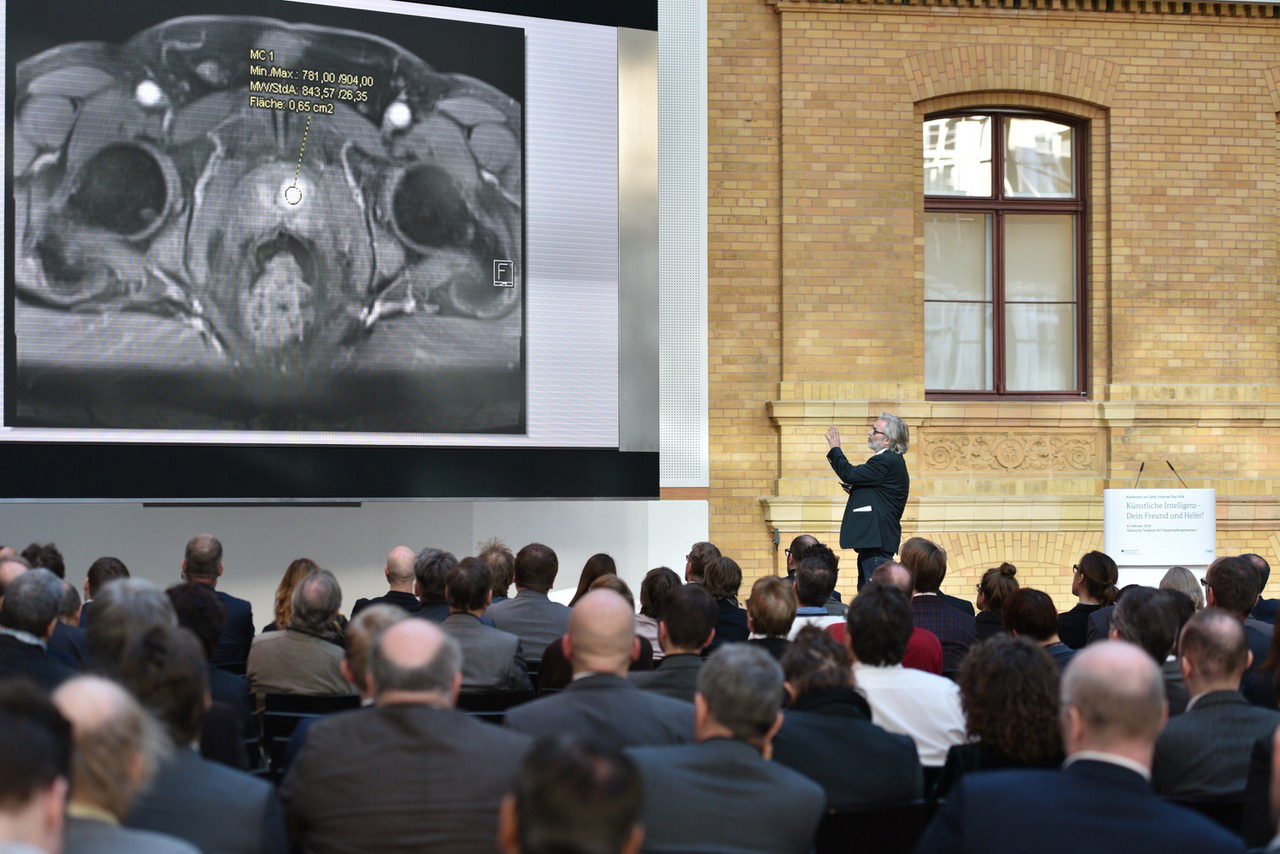

Und: Wir wollen, dass die Ärzte bei der Befundung eine Unterstützung erhalten. Man muss sich vorstellen, dass ein Radiologe den ganzen Tag an einem Bildschirm sitzt und nur Schwarz-Weiß-Bilder sieht. Eine multiparametrische MRT kann bis zu 2000 Schnitte haben, durch die er mit seiner Maus durchscrollen muss. In diesen vielen Grauwerten muss er die Läsionen und die suspekten Areale erkennen und diese Ergebnisse dann dem Urologen übermitteln. Dafür ist es sehr hilfreich, wenn er einen Hinweis bekommt, in welchem Slide eine Läsion zu erkennen oder zu vermuten ist.

In anderen Worten: Es geht dabei darum, Netze zu trainieren mit dem Wissen der erfahrenen Ärzte. Das machen wir mit von den erfahrenen Ärzten voran notierten Daten.

Gunnar Brune/AI.Hamburg: Herr Matthias Steffen, welches ist das spannendste aktuelle Projekt, an dem Sie arbeiten?

Matthias Steffen: Speziell im Healthcare-Bereich konzentrieren wir uns auf das Thema Prostata. Das nächste Thema, das sehr spannend ist, ist Genetik. Wie können wir in der Genetik AI einsetzen? Das menschliche Genom ist ja mittlerweile analysiert, aber was bedeutet das in der personalisierten Medizin? Was kann Künstliche Intelligenz hier leisten? Das ist eine ganz wichtige Fragestellung. Gerade ist der Nobelpreis für Medizin an die Entdeckerinnen der Genschere Crispr/Cas9 vergeben worden. Das ist ein riesiges Zukunftsfeld. Wir haben vor kurzem eine Arbeitsgruppe mit Wissenschaftlern aus diesem Bereich gegründet, um zum Thema Demenz zu forschen. Wir wollen wissen, welche genetischen und gesundheitlichen Parameter beachtet werden müssen, um eine Vorhersage machen zu können, wann einem Menschen Demenz droht. Wir wollen diese Vorhersage vor der Stunde Null machen, wenn die Demenz eintritt, damit man vorbeugend Medikamente geben kann. Das Thema Vorhersage interessiert uns auch generell. Stellen sie sich vor, sie kommen aus dem Skiurlaub und als Hamburger sind sie nicht ganz so gelenkig und haben sich Knie oder Oberschenkel gebrochen. Der Arzt kann bisher nicht wissen, wie sich in ihrem speziellen Fall der Heilungsverlauf darstellen wird. Ein normaler Bruch ist bei einem guten Verlauf nach 4-6 Wochen schon gut verheilt. Bei einem schlechten Verlauf kann es ein halbes bis zu einem ganzen Jahr dauern. Mit AI könnte man erklären, mit welchem Risiko sich ein Bruch schlecht entwickeln oder eben gut entwickeln wird, weil man das neuronale Netz mit vielen vergangenen Fällen trainiert hat.

Die Vorhersage ist das zentrale Thema neben der Bilderkennung. Im konkreten Fall könnten wir mit Künstlicher Intelligenz nach der MRT oder CT eine Vorhersage geben, wie sich der Bruch entwickeln wird. Wenn die Ärzte das schon vorher wüssten, dann wird das sehr interessant für die Behandlung und Therapie, die dann ganz anders aussehen kann. Mit so einer besseren/trefflichen Vorhersage würde die Therapie deutlich effektiver sein. Das könnte neben dem gesundheitlichen Vorteil auch einen Kostenvorteil für die Krankenkassen bedeuten.

Gunnar Brune/AI.Hamburg: Quasi ein Deus ex Machina dank dem Wissen der alten Ärzte? Wie konservieren Sie denn das Wissen der alten Ärzte?

Matthias Steffen: Wir brauchen für die AI annotiertes, also gelabeltes Material von den Radiologen, denn nur damit lernt unser System.

Wir sagen deshalb den Ärzten, dass sie eine sehr genaue Befundung für uns machen sollen. Dafür müssen sie das Organ im Bild genau umzeichnen. Diesen Befund nennen wir die Ground Truth, die Grundwahrheit. Wir müssen davon ausgehen, dass das, was der Chefarzt einzeichnet, die beste dafür mögliche Kennzeichnung ist. Auch die eventuell dort entdeckte Läsion, also das Krebsgeschwür, muss sehr genau umzeichnet werden. Im Alltag macht ein Arzt das normalerweise nicht so detailliert. Wir können also sehr sicher sein, gute Daten zu haben.

Gunnar Brune/AI.Hamburg: So mancher alte Hase lernt dann noch von Ihnen, wie gut er wirklich ist?

Matthias Steffen: Das würden wir uns nicht anmaßen. Aber wenn sie regelmäßig rund 500 Fälle haben, die sie von Radiologen bekommen und damit ihr Netz trainieren, dann werden sie immer besser sein als der beste Radiologe, weil wir ja auch immer wieder neu trainieren. In unserer Arbeit haben wir ebenso gesehen, wieviel die Erfahrung in der Radiologie ausmacht. Das ermutigt uns zu sagen, dass wir dank der mit den Daten der alten Chefärzte trainierten Künstlichen Intelligenz auch zur medizinische Qualität der Arbeit der jüngeren Radiologen beitragen können.

Der Prozess geht von der Radiologie bis zur Urologie. Es wird die Zeit kommen, dass die multiparametrischen Daten dazu geeignet sind, virtuelle 3D-Organe zu bilden, also digital nachgebildete Zwillinge von Organen. Das wird dann für die Planung und zielgenaue Biopsie des Organs genutzt.

Gunnar Brune/AI.Hamburg: Was ist das Besondere in der medizinischen Anwendung von AI?

Matthias Steffen: In der Medizin arbeiten wir in den Prozessen für Forschung und Entwicklung nicht viel anders als diejenigen, die zum Beispiel im Bereich Logistik arbeiten. Bei unseren medizinischen Anwendungen ist natürlich die Nachvollziehbarkeit unserer Ergebnisse besonders wichtig. Der TÜV Süd, TÜV Nord, oder eine andere benannte Stelle (staatlich benannte und überwachte Stellen, die für Hersteller prüfen, Anm. d. Red.) oder die FDA in den Vereinigten Staaten überprüfen die Ergebnisse unserer Netze. Hier müssen wir, anders als in der Logistik oder anderen Branchen, unter Beweis stellen, dass unsere Lösung besser ist als das, was bisher im Markt ist. Gerade bei den Amerikanern findet dazu ein ganz hartes Benchmarking statt. Wir müssen versuchen, immer wieder eine Steigerung gegenüber dem zu bringen, was schon im Markt ist. Wenn also eine bestehende Lösung eine Genauigkeit von 93 Prozent erreicht, dann müssen wir 94 Prozent erreichen. Das ist die besondere Herausforderung in der Medizin, weil es dort eben um Leben und Tod gehen kann.

Gunnar Brune/AI.Hamburg: Woher erhalten Sie die Daten, mit denen Sie arbeiten und trainieren?

Matthias Steffen: Das ist sehr schwierig. Es gibt einige, wie zum Beispiel Dr. med. Heiner Steffens von radprax, die sehr weitsichtig sind und einen Vertrag mit uns abschließen, der sie juristisch absichert und der auch den Prozess der Anonymisierung der Patientendaten beschreibt. Es gibt extra Tools für PACS-Systeme (Picture Archiving and Communication System – digitale Archivsysteme zur Verarbeitung, Verwaltung und Archivierung von medizinischen Bildern, Anm. d. Red.), die geeignet sind, die Namen und privaten Daten der Patienten aus den digitalen Daten herauszulöschen.

Gunnar Brune/AI.Hamburg: Das heißt, sie erhalten von Doktoren diese Dateien, diese werden anonymisiert und dann wird damit die Künstliche Intelligenz trainiert?

Matthias Steffen: Wenn die Daten in so einem PACS-System angekommen sind, wird der Radiologe von uns beauftragt, die Organe und Läsionen zu markieren. Das ist sehr aufwändig. Er schafft diese Arbeit vielleicht 20-30 mal an einem ganzen Tag. Aber das ist die Grundlage, um die AI trainieren zu können. Wenn wir die Daten direkt aus dem PACS-System bekämen, könnte unsere AI nichts damit anfangen. Sie muss erst lernen, wie das Organ aussieht, wie eine Läsion aussieht, und dann lernt das System. Danach erst kann das System generalisieren. Man hat dem Watson-Team von IBM oft vorgeworfen, dass es ganz viel Bildmaterial gesammelt und daraufhin verglichen habe. Aber das ist bei Künstlicher Intelligenz ja anders, weil sie generalisiert, so dass auch eine etwas andersartige Form als Läsion erkannt werden kann.

Gunnar Brune/AI.Hamburg: Wie stellen Sie sicher, dass die Ergebnisse neuronaler Netze nachvollziehbar sind?

Matthias Steffen: Das ist eine große Frage, wie sie auch von Verbraucherschützern oder vom Justizministerium gestellt wird: Ist die Arbeit von AI nachvollziehbar oder handelt es sich um eine Black Box? Hier gibt es bei uns den TÜV bzw. die benannte Stelle, die nach gesetzlichen und regulatorischen Vorgaben prüfen, ob das, was wir als Ziel ausgeben, auch so ist. Der TÜV kontrolliert anhand von neuen Daten, ob eine Prostata oder eine Läsion zuverlässig erkannt wird und ob das Ergebnis mit dem der Ärzte vergleichbar ist. Das Thema „Warum gibt es diese Ergebnisse oder sind sie aus einer Black Box“ ist eine Diskussion, die unter IT-Experten geführt wird, aber im Alltag und dem Verkauf dieser Lösungen keine Rolle spielt. Wichtig ist nur, und das müssen wir bei den benannten Stellen oder der FDA unter Beweis stellen, dass unsere Lösungen geeignet sind, die Leistungen der Radiologen zu übertreffen.

Interessant ist außerdem, noch mehr zu erkennen, z.B. Auffälligkeiten in der Zellstruktur oder an den Organen. Ich bin selbst kein Mediziner, aber diese „Drittmeinung“ bzw. der Hinweis auf weitere Dinge, das ist für die Radiologen oft sehr interessant.

Gunnar Brune/AI.Hamburg: Sie meinen Hinweise der AI, dass es weitere Auffälligkeiten gibt, die dazu Anlass geben insgesamt noch genauer hinzuschauen?

Matthias Steffen: Ja, genau, das wird auch sehr stark auf Kongressen diskutiert.

Gunnar Brune/AI.Hamburg: Was erwarten Sie in der Zukunft für diesen AI-Anwendungsbereich an weiterem Nutzen?

Matthias Steffen: Im Wesentlichen erleichtert AI natürlich den diagnostischen Prozess. Gleichzeitig bringt sie auch eine neue Effizienz, die Krankenkassen entlastet, die diese Behandlung bezahlen müssen. Für einen Privatpatient werden in den hier relevanten Fällen um die 500 – 800 Euro von der Krankenkasse erstattet, für einen gesetzlich versicherten Patient werden bis zu 100 Euro erstattet. Ein Radiologe macht am Tag rund 20 Befundungen. Wenn ein Radiologe in Zukunft 30 Befundungen machen kann, werden die Preise langfristig sinken. Das ist für die gesamte Gesundheitswirtschaft ein riesiger Vorteil.

Natürlich wird in allen Bereichen geforscht und Neues gefunden. So haben wir eine App entwickelt, die man auf die Hautoberfläche hält und die ein bösartiges Melanom oder eine einfache Keratose erkennen kann. Das kann eine großartige Lösung sein, um einem Patienten vorab etwas in Form einer Art von „Selbstdiagnose“ an die Hand zu geben. Die Dermatologen wünschen sich, dass Hautveränderungen gut dokumentiert werden und dass ein Hautkrebs in einem Frühstadium erkannt werden kann. Denn ein nicht erkannter Hautkrebs kann dazu führen, dass sich die Metastasen im ganzen Körper verbreiten.

Es gibt noch weitere Möglichkeiten für den Einsatz von AI. Unter den Kardiologen wird diskutiert, ob man nicht ein Gerät für ein Dreikanalkardiogramm entwickeln kann, das man einfach auf die Brust klebt, und das die Daten über WLAN auf eine App auf dem Smartphone und von dort weiter zu einem Kardiologen überträgt. So könnte man zum Beispiel den Verlauf der Heilung einer Herzoperation laufend beobachten. Wenn das System gelernt hat, welche Daten aus der App auf einen Notfall hinweisen, kann es wiederum einen Alarm beim Kardiologen auslösen.

Gunnar Brune/AI.Hamburg: Kollegin Künstliche Intelligenz. Wie gehen die Ärzte mit ihr um?

Matthias Steffen: Mit Blick auf die vergangenen 4-5 Jahre kann man sagen, dass zu Beginn AI bei den Kongressen auf große Ablehnung stieß. Jetzt gibt es sehr viele Lösungen – gerade von Universitäten entwickelt –, wie AI diagnostische Prozesse beschleunigen kann. Ich habe keine Umfragezahlen. Aber mein persönlicher Eindruck ist, dass sich die Akzeptanz von AI-Tools bei der Mehrzahl der Ärzten so verbessert hat, dass sie diese heute sofort einsetzen würden, weil sie von diesen Tools eine höhere medizinische Qualität und Patientennutzen erwarten. Ich glaube, dass die Ärzte sich langsam darauf einstellen, Künstliche Intelligenz einzusetzen. Ich habe auch ein Interview mit Herrn Tschentscher (Erster Bürgermeister von Hamburg und Mediziner, Anm. d. R.) geführt. Er sagte sinngemäß: „Warum werden so viele Fragen gestellt? Wir haben in der Labormedizin schon immer mit Algorithmen und Excel-Listen gearbeitet und versucht, Vorhersagen zu machen. Das ist jetzt nur eine konsequente Weiterentwicklung.“

Deshalb sind Ärzte von diesen technologischen Neuerungen nicht so weit entfernt. Hier in Hamburg gibt es zum Beispiel Herrn Professor Huland an der Martini-Klinik. In der Prostata-Diagnose hat er schon vor 30 Jahren angefangen, Daten zu sammeln. Er hat alle Patienten aus 30 Jahren in seiner Kartei und er kennt seine Patienten gut, weil er jedes Jahr einen Anamnesebogen an sie verschickt. Dieser hat übrigens die sehr hohe Rücklaufquote von rund 90 Prozent!

Gunnar Brune/AI.Hamburg: Wunderbar, wenn ich jetzt Radiologe wäre und von der AI profitieren will, dann rufe ich Sie an und sie stellen mir ein System für einen bestimmten Betrag hin. Richtig?

Matthias Steffen: Fast. Es bieten sich verschiedene Vertriebswege an, die wir jetzt einschlagen. So gibt es z.B. sogenannte Teleradiologieverbünde, wo an einem zentralen Ort ein Server, ein Hub etabliert wurde. Hier können Radiologen ihre Kollegen ansprechen, wenn sie z.B. bei einem Lungen-CT eine Zweitmeinung benötigen. Sie können die Daten über ein besonders geschütztes DICOM System (DICOM, Digital Imaging and Communications in Medicine) austauschen. Eins dieser Netzwerke hat 1000 Anschlüsse, ein anderes hat 500 Kliniken angeschlossen. Diese Netzwerke fragen mich: „Herr Steffen, wann sind sie endlich fertig?“ (lacht). Hätten wir in Deutschland doch mehr kluge Investoren und nicht nur die, die in Pizzadienste investieren! Wenn wir diese klugen Investoren gefunden hätten, dann wären wir natürlich auch weiter. Es gibt eine große Firma in Israel, Zebra Medical Vision, die wurde von Amerikanern und Isrealis sofort groß unterstützt. Alle machen in diesem Bereich fast das Gleiche und versuchen sich gegenseitig in der Genauigkeit zu übertrumpfen. Wie gehen wir vor? Wir verhandeln mit den Unternehmen wie Philips, Siemens oder GE, damit unsere Lösungen in deren PACS-Systemen integriert werden. Man muss sich das so vorstellen, dass der Arzt die Daten aus dem PACS-System entnimmt und durchscrollt. Er hat dabei die Möglichkeit, einen Button zu klicken, um das Organ und die Läsion angezeigt zu bekommen. Oder er kann, das planen wir gerade, die aufgenommenen Daten, auf einen Server legen, damit sie nachts von der AI schon vorbefundet werden. Der Radiologe kommt dann morgens an seinen Arbeitsplatz und die Daten aus den MRTs liegen vorbefundet bereit. So kann er sehr effizient arbeiten und in der gleichen Zeit fast das Doppelte leisten.

Gunnar Brune/AI.Hamburg: Sie haben schon eine große Erfahrung mit Künstlicher Intelligenz. Wenn Sie jetzt einem Mittelständler sprechen, der Sie fragt, wie man den Einstieg findet, was sagen sie ihm?

Matthias Steffen: Natürlich erstmal bei AI.Hamburg oder ARIC anrufen und sich beraten lassen. Das ist ja das Gute an diesen Organisationen, dass sie verschiedene Seminare für die Geschäftsleitung oder operative Ebene anbieten. So bildet man sich erstmal einen Überblick. Und dann muss natürlich ein Pilot umgesetzt werden. Wir haben mal einen Piloten umgesetzt für eine Firma, die Ölproben untersucht, um festzustellen, ob eine Maschine noch intakt ist. Dies erfolgt zum Beispiel bei Windkraftanlagen. Diese Proben durchlaufen verschiedene Prüfprozesse, die natürlich alle automatisiert werden könnten.

Gunnar Brune/AI.Hamburg: Was planen Sie als Nächstes?

Matthias Steffen: Der nächste Schritt ist die Zertifizierung nach den neuen Regularien von MDA IIa (Medical Device Regulation / Medizinprodukteverordnung der EU) und nach FDA, weil wir auch in den USA und in Asien tätig werden wollen. Wir möchten ein wenig wie Bosch Zündkerzen funktionieren, die auch unter den Marken Mercedes, Ford etc. verkauft werden. Es ist nicht wichtig, dass auf dem Produkt unser Name steht. Unser Ziel ist, als White-Label-Lösung bei Siemens, GE oder Philips integriert zu werden. Die Endkunden müssen nicht wissen, dass es von uns kommt.

Gunnar Brune/AI.Hamburg: Was sollte passieren, damit Künstliche Intelligenz schneller zum Durchbruch kommt?

Matthias Steffen: Ich würde sagen, man müsste ein Ministerium für Künstliche Intelligenz einrichten. Wenn wir nicht erkennen, dass AI auch in der Schule gelernt werden muss, dann haben wir verloren. Ich wünsche mir eine politische Institution, die die AI-Landschaft strukturiert und aufbaut und zwar auf Ministerialebene. Das wäre mein Wunsch. Übrigens nicht nur auf Bundesebene, auch in den Ländern.

Gunnar Brune/AI.Hamburg: Herr Steffen, vielen Dank für das Interview.

Das Interview führt Gunnar Brune von AI.Hamburg

Gunnar Brune

Gunnar Brune ist Marketing Evangelist, Strategie- und Storytellingexperte. Er ist Unternehmensberater mit Tricolore Marketing, Storyteller mit Narrative Impact, Gesellschafter des NEPTUN Crossmedia-Awards, Autor und mehrfaches Jurymitglied für Awards in den Bereichen Marketing, Kommunikation und Storytelling. Weiterhin ist Gunnar Brune im Enable2Grow Netzwerk assoziiert und engagiert sich im Rahmen von AI.Hamburg für die Vermittlung der Möglichkeiten und die Förderung des Einsatzes von Künstlicher Intelligenz.

Gunnar Brune ist Autor von dem Marketing Fachbuch „Frischer! Fruchtiger! Natürlicher!” und dem Bildband „Roadside”. Er ist Co-Autor der Bücher: “DIE ZEIT erklärt die Wirtschaft” und “Virale Kommunikation” und er schreibt seit vielen Jahren regelmäßig für Fachmagazine. Seine Artikel finden sich u.a. in der Advertising Age (Fachmagazin Werbung USA), Horizont, Fischers Archiv und der RUNDSCHAU für den Lebensmittelhandel.

Kontaktinformation:

Gunnar Brune, gunnar@ai.hamburg, 0176 5756 7777